NVIDIA와 Microsoft, 생성형 AI의 새로운 시대에 Windows PC를 위한 혁신 주도

마이크로소프트와 nvidia가 협업으로 기존 ai생성하는 속도를 거의 50프로 줄여주는 드라이버를 배포한다는 뉴스가 있네요.

개인적으로 요새 SD Webui를 가지고 놀고 있는데, m1이라 별 기대는 없지만,

구형 윈도우에서도 속도 향상이 된다면, 윈도우를 오래간만에 켜보는 일이 있을 것 같기도 하네요.

아래 내용은

nvidia 홈페이지에서 번역한 내용임을 미리 밝힙니다.

Driving Innovation for Windows PCs in Generative AI Era | NVIDIA Blog

At the Microsoft Build developer conference, NVIDIA and Microsoft showcased a suite of advancements in Windows 11 PCs and workstations with NVIDIA RTX GPUs.

blogs.nvidia.com

업계 리더들은 개발자가 Windows 11에서 고급 AI 모델을 쉽게 훈련 및 배포하고 RTX PC 및 워크스테이션에서 전력 효율적인 추론을 제공할 수 있도록 장벽을 허물고 있습니다.

NVIDIA와 Microsoft는 Windows 11 PC와 워크스테이션에서 NVIDIA RTX GPU를 활용하여 제너레이티브 AI의 요구 사항을 충족하는 일련의 발전을 선보였습니다. 이를 위해 AI 개발 도구, AI를 최적화하고 배포하기 위한 프레임워크, 드라이버 성능 및 효율성 개선 등이 발표되었습니다. 이러한 발전은 개발자들이 제너레이티브 AI를 핵심으로 한 다음 세대의 Windows 앱을 구축하는 데 도움이 될 것입니다. 또한, Windows Subsystem for Linux (WSL)을 통해 개발자들은 Windows PC에서 GPU 가속화된 딥러닝 프레임워크를 사용하여 로컬 AI 개발을 수행할 수 있게 되었습니다. NVIDIA의 RTX GPU는 대용량 메모리를 제공하며, 로컬에서 AI 모델의 세부 조정과 성능 향상에 기여합니다. 이러한 발전은 Windows 애플리케이션에서 AI가 중요한 역할을 하는 상황에서 추론 성능을 효율적으로 제공하는 데 중요한 역할을 합니다.

모델의 신속한 최적화 및 구현

훈련된 모델을 손에 쥐고 있는 개발자는 대상 장치에 AI를 최적화하고 배치해야 합니다.

Microsoft는 PyTorch 모델을 최적화하고 ONNX로 변환하기 위해 Microsoft Olive 툴체인을 출시하여 개발자들이 RTX Tensor Core와 같은 GPU 하드웨어 가속화를 자동으로 활용할 수 있도록 지원했습니다.개발자는 Olive 및 ONNX를 통해 모델을 최적화하고 Tensor Core 가속 모델을 PC 또는 클라우드에 배포할 수 있습니다. Microsoft는 PyTorch 및 관련 도구와 프레임워크가 WSL과 원활하게 작동하여 최고의 AI 모델 개발 경험을 제공하도록 지속적으로 투자하고 있습니다.

향상된 AI 성능, 전력 효율성

일단 배치되면 생성 AI 모델은 놀라운 추론 성능을 요구합니다.RTX 텐서 코어는 AI 추론을 위해 최대 1,400개의 텐서 TFLOPS를 제공합니다. 지난 1년 동안 NVIDIA는 DirectML 성능을 개선하여 RTX 하드웨어를 최대한 활용하기 위해 노력해 왔습니다.

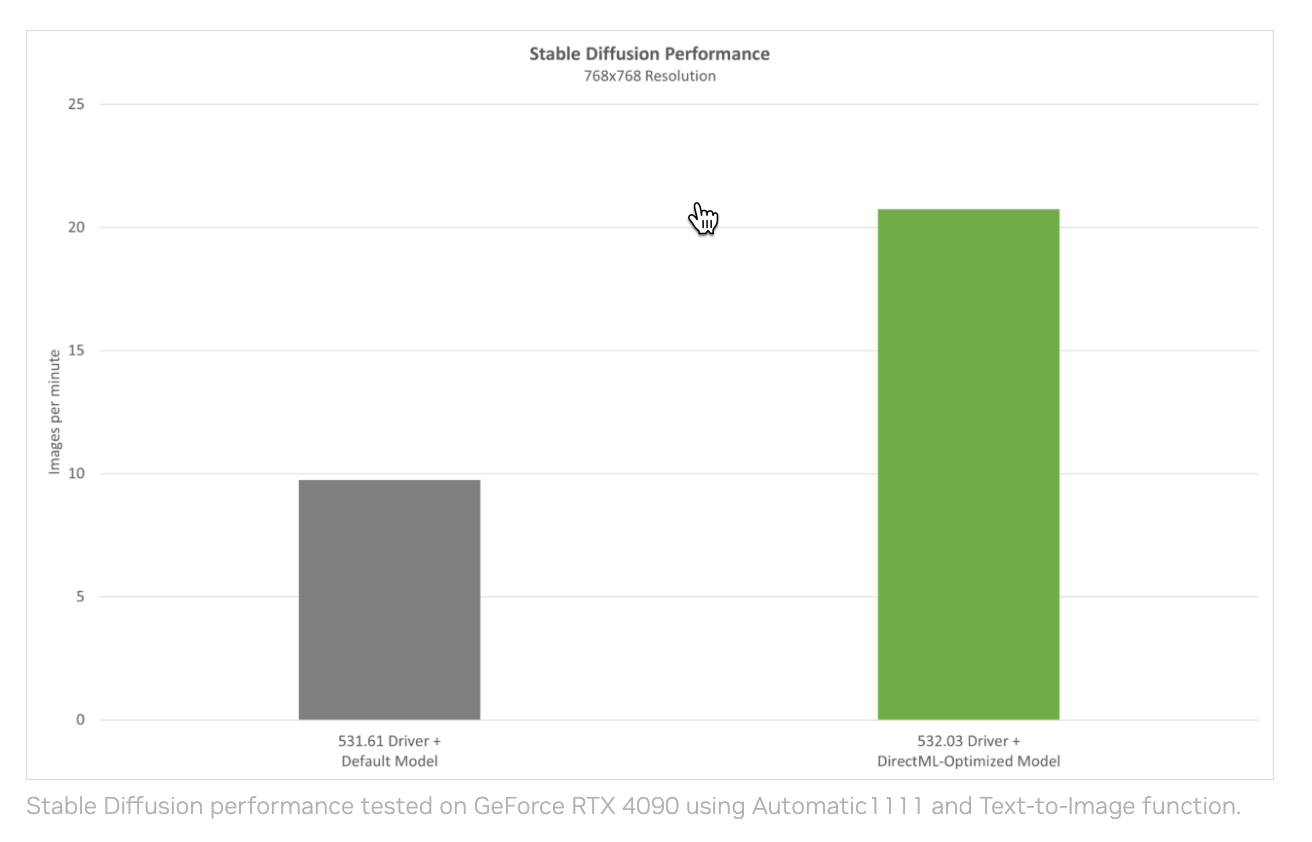

5월 24일에는 Olive에 최적화된 모델과 결합하여 AI 성능을 크게 향상시키는 릴리즈 532.03 드라이버의 최신 최적화 기능을 발표할 예정입니다. 인기 있는 Automatic1111 배포와 함께 안정적인 확산 텍스트-이미지 생성기의 올리브 최적화 버전을 사용하여 새로운 드라이버로 성능이 2배 이상 향상되었습니다.

Chart showing performance improvements in Stable Diffusion with updated NVIDIA drivers.

GeForce RTX 4090에서 Automatic1111 및 Text-to-Image 기능을 사용하여 안정적인 확산 성능을 테스트했습니다.

AI가 거의 모든 Windows 애플리케이션에 적용됨에 따라 특히 노트북의 경우 추론 성능을 효율적으로 제공하는 것이 중요합니다.NVIDIA는 조만간 RTX GPU의 AI 전용 워크로드를 위한 새로운 Max-Q 저전력 추론을 도입할 예정입니다. GPU의 전력 소비를 최대한 낮게 유지하면서 Tensor Core 성능을 최적화하여 배터리 수명을 연장하고 시원하고 조용한 시스템을 유지합니다. 그러면 GPU는 워크로드가 요구할 때 최대 AI 성능을 위해 동적으로 확장할 수 있습니다.

소개만 잠시 하고 내일 한번 확인해보시죠.

그럼 다음시간에 만나요.

'IT' 카테고리의 다른 글

| tk.h version (8.5) doesn't match libtk.a version (8.6) 에러 해결 (0) | 2023.05.25 |

|---|---|

| 시놀로지에서 Plex 패키지 업데이트 하는 법 (1) | 2023.05.25 |

| 맥(mac)에서 아이무비로 사진을 동영상으로 만드는 방법 (0) | 2023.05.22 |

| 구글 애널리틱스에 애드센스 연결하기 (0) | 2023.05.18 |

| 구글 서치 콘솔 페이지 찾을 수 없음 (404)에러 해결 (0) | 2023.05.07 |